Clicca l'iniziale per trovare la parola cercata

A B C

D E F

G H I J K

L M N O

S T U V W X Y Z

P Q R

Paradosso di Jevons.

E' un'osservazione di William Stanley Jevons che affermò che i miglioramenti tecnologici che aumentano l'efficienza con cui una risorsa è usata possono fare aumentare il consumo totale di quella risorsa, invece di farlo diminuire. È chiamato paradosso perché le sue conclusioni vanno contro il senso comune, ma non si tratta in realtà di un paradosso ed è accettato nelle teorie economiche attuali. L'aumento di efficienza si traduce normalmente in una diminuzione di costi che, in genere, aumenta i consumi. Se tale aumento avvenga o meno dipende però dall'elasticità della domanda. Se la domanda è abbastanza rigida, una variazione di prezzo non indurrà sensibili variazioni nel consumo dell'output, e quindi indurrà una diminuzione del consumo dell'input della risorsa. Viceversa se la domanda è elastica, quindi variazioni nel prezzo producono significativi aumenti nel consumo dell'output, ci saranno incrementi anche nell'input. Si tratta di quello che viene chiamato 'effetto rebound'. Il paradosso è enunciato nel libro del 1865, The Coal Question, dove Jevons osservava che il consumo inglese di carbone era cresciuto dopo che James Watt aveva introdotto il motore a vapore (alimentato a carbone), che migliorò notevolmente l'efficienza del precedente motore di Thomas Newcomen. Le innovazioni di Watt resero il carbone una fonte di energia più redditizia, cosa che condusse ad un suo maggiore uso in una vasta gamma di processi produttivi. Il consumo totale di carbone aumentò, anche se nel frattempo la quantità di carbone richiesta per produrre il medesimo lavoro era diminuita.

Peta

In metrologia, Peta (simbolo P) è un prefisso del sistema di unità SI ed esprime il fattore 10exp15 cioè 1 000 000 000 000 000.

Pannelli fotovoltaici

I pannelli fotovoltaici sono costituiti da celle fotovoltaiche (o da moduli fotovoltaici) e consentono di convertire la luce solare direttamente in energia elettrica. Le celle, che costituiscono i componenti base dei pannelli, sfruttano l'effetto fotovoltaico e hanno un’efficienza di conversione teorica (da energia solare a energia elettrica) pari al 32 %. In pratica, producendo celle e pannelli a livello industriale e realizzando con i pannelli un campo fotovoltaico si possono ottenere efficienze attorno al 15%. Ad esempio, un impianto da 1 kW di potenza produce, nell’Italia meridionale, circa 1.600 kWh di energia. Questi pannelli, non avendo parti mobili, necessitano di pochissima manutenzione; in sostanza vanno solo puliti periodicamente; ogni dieci anni circa vanno sostituiti gli inverter che trasformano la tensione da continua in alternata. La durata operativa stimata dei pannelli fotovoltaici è di circa 30 anni. Il limite degli impianti fotovoltaici è rappresentato dal costo dei pannelli. E’ solo grazie a una legislazione che prevede incentivi economici all'installazione di impianti fotovoltaici e la possibilità di vendere, a tariffe agevolate, l'energia prodotta al gestore della rete di trasmissione, che la Germania è al primo posto al mondo per la potenza elettrica prodotta da energia solare. Analoghe iniziative, comunemente note come Conto Energia o Feed-in tariff, sono state intraprese da diversi stati europei che hanno ratificato il Protocollo di Kyoto, tra cui anche l'Italia. Per maggiori dettagli vedi la voce moduli fotovoltaici. Giova notare che a volte si confondono i termini pannello e modulo.

Due pannelli formati ognuno da 12 moduli fotovoltaici montati su supporti a inseguimento solare.

Pannelli solari termici

I pannelli solari o collettori termici possono essere a circolazione naturale o forzata; i primi utilizzano il moto convettivo del liquido contenuto nei pannelli per consentirne la circolazione all'interno del sistema pannello-scambiatore di calore. In questo caso il serbatoio di accumulo che contiene lo scambiatore di calore deve trovarsi più in alto del pannello. I sistemi a circolazione forzata, invece, utilizzano una pompa che fa circolare il fluido all'interno di scambiatore e pannello quando la temperatura del fluido all'interno del pannello è più alta di quella all'interno del serbatoio di accumulo. Sistemi di questo tipo sono più complessi dal punto di vista dei controlli e delle apparecchiature impiegate (pompe, sensori di temperatura, valvole a tre vie, centraline di controllo), ma consentono di posizionare il serbatoio di accumulo, anche di grandi dimensioni, praticamente dove si vuole, ad esempio a terra e non sul tetto dove problemi di peso potrebbero renderne difficile la collocazione.

Schema di un pannello solare:

1)Valvola

2)Serbatoio di accumulo

3)Condotto di inserimento

4)Pannello di assorbimento

5)Condotto di inserimento dell'acqua fredda

Pannelli solari a concentrazione

Il pannello solare a concentrazione concentra i raggi solari su un opportuno ricevitore; attualmente il tipo più usato è quello a specchi parabolici a struttura lineare che consente un orientamento monodimensionale (più economico) verso il sole e l'utilizzo di un tubo ricevitore in cui è fatto scorrere un fluido termovettore per il successivo accumulo di energia in appositi serbatoi. Il vettore classico è costituito da olii minerali in grado di sopportare alte temperature. Nel 2001 l'ENEA ha avviato lo sviluppo del progetto Archimede, volto all'utilizzo di sali fusi anche negli impianti a specchi parabolici a struttura lineare. Essendo necessaria una temperatura molto più alta di quella consentita dagli olii, si è provveduto a progettare e realizzare tubi ricevitori in grado di sopportare temperature maggiori di 600°C (contro quelle di 400°C massimi dei tubi in commercio), ricoperti di un doppio strato CERMET (ceramica/metallo) depositato con procedimento di sputtering. I sali fusi vengono accumulati in un grande serbatoio coibentato alla temperatura di 550°C. A tale temperatura è possibile immagazzinare energia per 1KWh equivalente con appena 5 litri di sali fusi. Da tale serbatoio i sali - un comune fertilizzante per agricoltura costituito da un 60% di nitrato di sodio (NaNO3) e un 40% di nitrato di potassio (KNO3) - vengono estratti e utilizzati per produrre vapore surriscaldato. I sali utilizzati vengono accumulati in un secondo serbatoio a temperatura più bassa (290°C). Ciò consente la generazione di vapore in modo svincolato dalla captazione dell'energia solare (di notte o con scarsa insolazione). L'impianto, lavorando ad una temperatura di regime di 550°C, consente la produzione di vapore alla stessa temperatura e pressione di quello utilizzato nelle centrali elettriche a coproduzione (turbina a gas e riutilizzo dei gas di scarico per produrre vapore), consentendo consistenti riduzioni di costi e sinergie con le stesse. Attualmente è stato realizzato un impianto con tali caratteristiche in Spagna ed è stato siglato un accordo di realizzazione di un impianto su scala industriale presso la centrale termoelettrica ENEL ubicata a Priolo Gargallo (Siracusa).

Particolato atmosferico.

Particolato, particolato sospeso, pulviscolo atmosferico, polveri sottili, polveri totali sospese (PTS), sono termini che identificano comunemente l'insieme delle sostanze sospese in aria (fibre, particelle carboniose, metalli, silice, inquinanti liquidi o solidi). Il particolato è l'inquinante che oggi è considerato di maggiore impatto nelle aree urbane, ed è composto da tutte quelle particelle solide e liquide disperse nell'atmosfera, con un diametro che va da pochi nanometri fino ai 500 micron e oltre.

Sorgenti

Gli elementi che concorrono alla formazione di questi aggregati sospesi nell'aria sono numerosi e comprendono fattori sia naturali che antropici, con diversa pericolosità a seconda dei casi. Fra i fattori naturali vi sono ad esempio:

polvere, terra, sale marino alzati dal vento (il cosiddetto "aerosol marino"),

incendi,

microrganismi,

pollini e spore,

erosione di rocce,

eruzioni vulcaniche,

polvere cosmica.

Fra i fattori antropici si include gran parte degli inquinanti atmosferici:

emissioni della combustione dei motori a combustione interna (autocarri, automobili, aeroplani);

emissioni del riscaldamento domestico (in particolare gasolio, carbone e legna);

residui dell'usura del manto stradale, dei freni e delle gomme delle vetture;

emissioni di lavorazioni meccaniche, dei cementifici, dei cantieri;

lavorazioni agricole;

inceneritori e centrali elettriche;

fumo di tabacco.

Il rapporto fra fattori naturali ed antropici è molto differente a seconda dei luoghi. È stato stimato che in generale le sorgenti naturali contribuiscono per il 94% del totale lasciando al fattore umano meno del 10%. Tuttavia queste proporzioni cambiano notevolmente nelle aree urbane dove l'apporto preponderante sono senza dubbio il traffico stradale e il riscaldamento domestico (ma quest'ultimo molto poco se si utilizzano caldaie a gas), nonché eventuali impianti industriali (raffinerie, cementifici, centrali termoelettriche, inceneritori ecc.).

Altro aspetto riguarda la composizione di queste polveri. In genere, il particolato prodotto da processi di combustione, siano essi di origine naturale (incendi) o antropica (motori, riscaldamento, legna da ardere, industrie, centrali elettriche, ecc.), è caratterizzato dalla presenza preponderante di carbonio e sottoprodotti della combustione; si definisce pertanto "particolato carbonioso". Esso è considerato, in linea di massima e con le dovute eccezioni, più nocivo nel caso in cui sia prodotto dalla combustione di materiali organici particolari quali ad esempio le plastiche, perché può trasportare facilmente sostanze tossiche che residuano da tale genere di combustione (composti organici volatili, diossine, ecc.). Per quanto riguarda i particolati "naturali", molto dipende dalla loro natura, in quanto si va da particolati aggressivi per le infrastrutture quale l'aerosol marino (fenomeni di corrosione e danni a strutture cementizie), a particolati nocivi come terra o pollini, per finire con particolati estremamente nocivi come l'asbesto. Un'altra fonte sono le ceneri vulcaniche disperse nell'ambiente dalle eruzioni che sono spesso all'origine di problemi respiratori nelle zone particolarmente esposte e molto raramente possono addirittura raggiungere quantità tali che, proiettate a una quota, possono rimanere nell'alta atmosfera per anni e sono in grado di modificare radicalmente il clima.

Importanza delle sorgenti antropiche

La questione è molto dibattuta. In generale, negli impianti di combustione non dotati di tecnologie specifiche, pare accertato che il diametro delle polveri sia tanto minore quanto maggiore è la temperatura di esercizio. In qualunque impianto di combustione (dalle caldaie agli inceneritori fino ai motori delle automobili e dei camion) un innalzamento della temperatura (al di sotto comunque di un limite massimo) migliora l'efficienza della combustione e dovrebbe perciò diminuire la quantità complessiva di materiali parzialmente incombusti (dunque di particolato). Lo SCENIHR (Scientific Committee on Emerging and Newly Identified Health Risks) comitato scientifico UE che si occupa dei nuovi/futuri rischi per la salute, considera i motori a gasolio e le auto con catalizzatori freddi o danneggiati i massimi responsabili della produzione di nanoparticelle. Lo SCHER (Scientific Committee on Health and Environmental Risks, Comitato UE per i rischi per la salute e ambientali) afferma che le maggiori emissioni di polveri fini (questa la dicitura esatta usata, intendendo PM2,5) è data dagli scarichi dei veicoli, dalla combustione di carbone o legna da ardere, processi industriali e altre combustioni di biomasse.

Naturalmente, in prossimità di impianti industriali come cementifici, altiforni, centrali a carbone, inceneritori e simili, è possibile (a seconda delle tecnologie e delle normative in atto) rilevare o ipotizzare un maggiore contributo di tali sorgenti rispetto al traffico. Secondo i dati dell'APAT (Agenzia per la protezione dell'ambiente) riferiti al 2003, la produzione di PM10 in Italia deriverebbe: per il 49% dai trasporti; per il 27% dall'industria; per l'11% dal settore residenziale e terziario; per il 9% dal settore agricoltura e foreste; per il 4% dalla produzione di energia. Secondo uno studio del CSST su incarico dell'Automobile Club Italia, sul totale delle emissioni di PM10 in Italia il 29% deriverebbe dagli autoveicoli a gasolio, e in particolare l'8% dalle automobili in generale e l'1-2% dalle auto Euro3 ed Euro4.

Si segnalano alcuni dubbi sulla formazione di polveri fini, ultrafini e nanopolveri che i filtri antiparticolato emetterebbero soprattutto nelle fasi di rigenerazione periodica.

In ogni caso, la determinazione dei contributi percentuali delle varie fonti è un'operazione di estrema complessità e occasione di continue polemiche fra i diversi settori produttivi, ulteriormente accentuate dai fortissimi interessi economici in gioco.

Classificazione qualitativa

In base alle dimensioni (µm = micron, micròmetro o milionesimo di metro) e alla natura delle particelle si possono elencare le seguenti classi qualitative di particolato:

Aerosol: particelle liquide o solide sospese di diametro minore di 1 µm; sono dispersioni di tipo colloidale, che causano, ad esempio, all'alba e al tramonto, l'effetto Tyndall, facendo virare il colore della luce solare verso l'arancione.

Esalazioni: particelle solide di diametro inferiore a 1 µm, in genere prodotte da processi industriali.

Foschie: goccioline di liquido di diametro inferiore a 2 µm.

Fumi: particelle solide disperse di diametro inferiore a 2 µm, trasportate da prodotti della combustione.

Polveri: particelle solide di diametro variabile tra 0,25 e 500 µm.

Sabbie: particelle solide di diametro maggiore di 500 µm.

Identificazione e misura quantitativa

La quantità totale di polveri sospese è in genere misurata in maniera quantitativa (peso / volume). In assenza di inquinanti atmosferici particolari, il pulviscolo contenuto nell'aria raggiunge concentrazioni diverse (mg/m3) nei diversi ambienti, generalmente è minimo in zone di alta montagna, e aumenta spostandosi dalla campagna alla città, alle aree industriali.

L'insieme delle polveri totali sospese (PTS) può essere scomposto a seconda della distribuzione delle dimensioni delle particelle. Le particelle sospese possono essere campionate mediante filtri di determinate dimensioni, analizzate quantitativamente ed identificate in base al loro massimo diametro aerodinamico equivalente (dae). Tenuto conto che il particolato è in realtà costituito da particelle di diversa densità e forma, il dae permette di uniformare e caratterizzare univocamente il comportamento aerodinamico delle particelle rapportando il diametro di queste col diametro di una particella sferica avente densità unitaria (1 g/cm3) e medesimo comportamento aerodinamico (in particolare velocità di sedimentazione e capacità di diffondere entro filtri di determinate dimensioni) nelle stesse condizioni di temperatura, pressione e umidità relativa.

Si utilizza un identificativo formale delle dimensioni, il Particulate Matter, abbreviato in PM, seguito dal diametro aerodinamico massimo delle particelle.

Ad esempio si parla di PM10 per tutte le particelle con diametro inferiore a 10 µm, pertanto il PM2,5 è un sottoinsieme del PM10, che a sua volta è un sottoinsieme del particolato grossolano ecc.

In particolare:

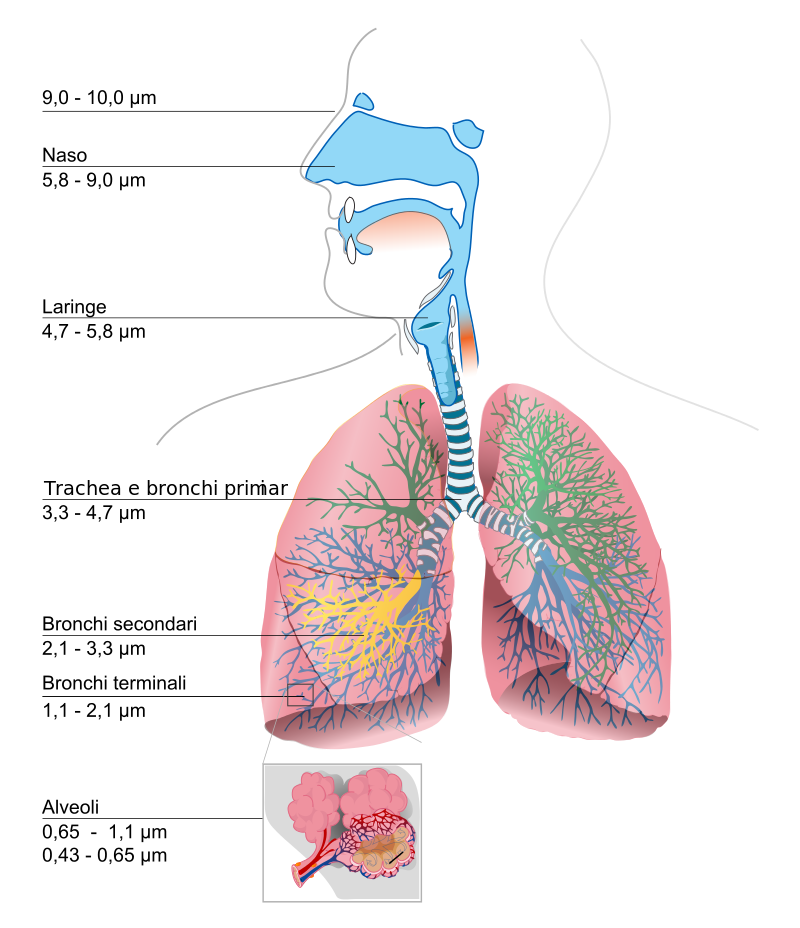

Particolato grossolano particolato sedimentabile di dimensioni superiori ai 10 µm, non in grado di penetrare nel tratto respiratorio superando la laringe, se non in piccola parte.

PM10 particolato formato da particelle inferiori a 10 micron (µm) (cioè inferiori a un centesimo di millimetro), è una polvere inalabile, ovvero in grado di penetrare nel tratto respiratorio superiore (naso e laringe). Le particelle fra circa 5 e 2,5 µm si depositano prima dei bronchioli.

PM2,5 particolato fine con diametro inferiore a 2,5 µm (un quarto di centesimo di millimetro), è una polvere toracica, cioè in grado di penetrare profondamente nei polmoni, specie durante la respirazione dalla bocca.

Per dimensioni ancora inferiori (particolato ultrafine, UFP o UP) si parla di polvere respirabile, cioè in grado di penetrare profondamente nei polmoni fino agli alveoli; vi sono discordanze tra le fonti per quanto riguarda la loro definizione, per quanto sia più comune e accettata la definizione di UFP come PM0,1 piuttosto che come PM1 (di cui comunque sono un sottoinsieme):

PM1, con diametro inferiore a 1 µm

PM0,1, con diametro inferiore a 0,1 µm

nanopolveri, con diametro dell'ordine di grandezza dei nanometri (un nanometro sarebbe PM 0,001).

Hinds suddivide il particolato in tre categorie generiche, anche a seconda del meccanismo di formazione:

particolato ultrafine (UFP), con diametro infiriore a 0,1 µm e formato principalmente da residui della combustione (PM0,1)

particolato formato dall'aggregazione delle particelle più piccole, compreso tra 0,1 e 2,5 µm in diametro (PM2,5)

particolato formato da particelle più grossolane (maggiore di 2,5 µm) generate mediante processi meccanici da particelle più grandi.

Distribuzione delle polveri nell'apparato respiratorio

Pedologia.

La pedologia (dal greco pedon, suolo e logos, studio) è la scienza che studia la composizione, la genesi e le modificazioni del suolo, dovute sia a fattori biotici che abiotici. È una branca delle scienze della Terra in genere e dell'agronomia. Suo padre fondatore è ritenuto il geografo russo Vasilij Dokucaev.

Pericolosità della corrente elettrica

La soglia di percezione della correnti elettrica nell'uomo è circa di 0,5 mA in c.a. (corrente alternata) a frequenza industriale (f = 50÷60 Hz) e di 2 mA in c.c. (corrente continua), inoltre si deve tenere conto che l'effetto di una determinata corrente elettrica varia non solo per l'intensità, ma anche per la durata della percorrenza. Si noti che la tensione non è rilevante negli effetti sull'uomo, ma occorre una tensione minima per essere attraversati dalla corrente, quindi sotto i 50 V circa non si corrono rischi, ma al di sopra è ininfluente la tensione, gli effetti dipendono solo dall'intensità. Con intensità maggiori a quelle specificate si producono nel corpo umano i seguenti effetti:

- Tetanizzazione muscolare: i muscoli sottoposti ad una corrente alternata, subiscono una sequenza di stimoli elettrici; non riuscendo a contrarsi e rilassarsi con la frequenza della corrente, i muscoli restano contratti permanentemente. Tale circostanza è particolarmente grave quando un oggetto in tensione viene impugnato volontariamente, poiché la tetanizzazione paralizza i muscoli impedendone il rilascio; la massima corrente per la quale si riesce a lasciare la presa viene chiamata corrente di rilascio e si aggira sui 10÷30 mA a f.i. (frequenza industriale).

- Blocco respiratorio: tetanizzazione dei muscoli respiratori quando il contatto interessa la regione toracico-polmonare. Comporta ipossia quindi danni al cervello dopo pochi minuti.

- Fibrillazione ventricolare: una corrente alternata sufficientemente elevata (> 50 mA) che interessi la regione toracica può provocare la perdita di coordinamento dei muscoli cardiaci, così il cuore non riesce più a pompare sangue causando ipossia e danni al cervello.

- Arresto cardiaco.

- Ustioni: dovuta ad elevati densità di corrente tra cute e conduttore in tensione, per effetto Joule, provoca elevante temperature per brevi periodi capaci di provocare gravi ustioni.

- Limiti di corrente:

- Si definisce soglia media di pericolosità:

- dove con Ip : corrente pericolosa e Δt: tempo di permanenza; questa individua il limite al di sotto del quale la corrente è percepibile ma non pericolosa; al di sopra di esso la corrente deve considerarsi potenzialmente pericolosa.

- I parametri dell'equazione si possono assumere, a frequenza industriale:

.

.

- Limiti di tensione:

- Il corpo umano presenta prevalentemente un comportamento resistivo: la tensione

che corrisponde alla corrente pericolosa è di difficile definizione perché la resistenza del corpo Ru può variare in un campo molto ampio, dipendendo da molteplici fattori quali i punti di contatto, l'estensione del contatto, la pressione, lo spessore della pelle e il suo grado di umidità. Si assume Ru > 2000Ω, per questo motivo non vengono ritenute pericolose tensioni sinusoidali con valore efficace U < 50V e tensioni continue con U < 120V, applicate per un tempo illimitato.

che corrisponde alla corrente pericolosa è di difficile definizione perché la resistenza del corpo Ru può variare in un campo molto ampio, dipendendo da molteplici fattori quali i punti di contatto, l'estensione del contatto, la pressione, lo spessore della pelle e il suo grado di umidità. Si assume Ru > 2000Ω, per questo motivo non vengono ritenute pericolose tensioni sinusoidali con valore efficace U < 50V e tensioni continue con U < 120V, applicate per un tempo illimitato.

Una persona può venire a contatto con parti in tensione e quindi subire gli effetti del passaggio di corrente mediante contatto diretto oppure contatto indiretto. Quindi per evitare ciò si devo attuare delle contromisure imposte dalla norma vigente (norme CEI). La protezione contro i contatti diretti si attuano prevenendo i contatti accidentali con le parti in tensione:

- isolamento delle parti attive con materiale isolante non removibile,

- involucri o barriere tali da impedire ogni contatto con le parti in tensione,

- ostacoli o distanziatori,

- interruttori differenziali ad alta sensibilità, con correnti differenziali di soglia di Is ≤30 mA

La protezione contro i contatti indiretti si realizza nei seguenti modi:

- Messa a terra delle masse,

- Interruzione automatica dell'alimentazione tramite interruttori automatici,

- Doppio isolamento delle apparecchiature

- Separazione elettrica

Petrolio

Al pari del carbone e del gas naturale, anche il petrolio è una fonte fossile di origine organica. In particolare è composto da una miscela assai complessa di idrocarburi liquidi, solidi e gassosi, con presenza più o meno limitata di sostanze organiche ossigenate, azotate e solforate di diversa natura. La distribuzione mondiale delle riserve accertate di petrolio indica una forte concentrazione (oltre il 66%) nel Medio Oriente e in alcune aree dell’Asia, dell’Africa e dell’Europa orientale, mentre molto più modesti sono i giacimenti nelle altre aree del Pianeta. Per poter essere impiegato sul piano industriale il petrolio necessita di raffinazione. Con questo termine si intende un insieme di processi che hanno lo scopo di isolare dal greggio sostanze o miscele di sostanze adatte a vari impieghi, principalmente in campo energetico (carburanti per autotrazione, combustibili per centrali termoelettriche o per il riscaldamento), ma anche per altri usi, ad esempio per ricavare solventi, lubrificanti, bitumi oppure intermedi di base per l’industria petrolchimica (su cui si fonda la fabbricazione di numerosi prodotti di sintesi come materie plastiche, prodotti sintetici, detergenti, ecc.). Nonostante la lenta erosione della sua quota sui consumi primari di energia nel mondo, il petrolio è, e rimarrà ancora a lungo, la fonte energetica più utilizzata. Oltre il 37% dei consumi energetici mondiali è assicurato dal petrolio. In particolare, nell’America Centrale e Meridionale i consumi petroliferi rappresentano oltre il 45% del totale, mentre si attestano intorno al 40% nel continente nordamericano, in Africa e nell’Europa occidentale. All’interno dell’Unione Europea spicca il dato dell’Italia dove i consumi petroliferi rappresentano la quota preponderante (oltre il 48%) del fabbisogno energetico nazionale. Si tratta di un “primato” assai poco consolante per la fattura energetica nazionale, ove il petrolio gioca un ruolo preponderante essendo la fonte di energia più costosa. Il petrolio, infatti, come del resto anche le altre fonti fossili, è quasi interamente importato dall’Italia, con un grado di dipendenza dall'estero stabilmente superiore al 93%. In particolare, l’approvvigionamento nazionale di petrolio è assicurato per circa il 70% dal Medio Oriente e dal Nord Africa e, per la quota restante, dalla Federazione Russa e da altri Paesi europei. Tuttavia, se resta elevata in Italia la quota dei consumi petroliferi, si va sensibilmente modificando il quadro degli impieghi dei prodotti derivati dal petrolio. In particolare, nel settore termoelettrico si sta assistendo nel nostro Paese a un ricorso sempre più limitato all’olio combustibile a vantaggio del “carbone pulito” e del gas naturale. Questa tendenza è fortemente sostenuta da Enel, il cui piano di riconversione del proprio parco centrali punta, per ragioni ambientali ed economiche, a un sostanziale azzeramento entro il 2008 dell’uso di olio combustibile.

Riserve di petrolio Prospettive sulla diminuzione dei rimanenti 57 Z-Joule di petrolio sul pianeta. Il consumo annuo di petrolio era di 0,18 ZJ nel 2005. Esiste un'incertezza significativa attorno a questi numeri. Gli 11 ZJ che si prospettano come addendi futuri alle riserve recuperabili potrebbero essere troppo ottimistici. (Z = 10exp19)

Picco di Hubbert

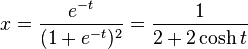

La curva di Hubbert (o hubbertiana), così chiamata dal geofisico M. King Hubbert è una derivazione della funzione logistica. Un esempio della curva di Hubbert può essere espressa come:

La curva è molto simile, ma non identica, ad una distribuzione normale. È stata inizialmente intesa come modello per la stima della quantità di petrolio estraibile da un giacimento. Secondo questo modello, la quantità del petrolio estratto, e quindi prodotto, è determinata dalla velocità nello scoprire nuovi giacimenti petroliferi. Superato il punto di massima della funzione, (detto picco di Hubbert) si avrà un declino dell'estrazione di petrolio che tenderà infine a zero. Hubbert applicò per la prima volta il suo modello alla produzione petrolifera degli Stati Uniti, riuscendo a prevedere con dieci anni di anticipo che questa avrebbe raggiunto il suo massimo all'inizio degli anni settanta. In figura la curva di Hubbert.

Sulla base degli studi intorno al Picco di Hubbert per la risorsa petrolifera sono sorte diverse teorie scientifiche e, principalmente, economiche e politiche, alcune delle quali anche di stampo più o meno "catastrofista". Vogliamo qui solo menzionare, tra le più importanti, la teoria di Olduvai proposta da Richard Duncan, che lega l'esistenza stessa della civiltà industriale all'inclinazione "crescente" della curva di Hubbert, giungendo dunque a prevedere la fine di tale tipo di civiltà in un'epoca di curva di Hubbert "decrescente". Questo ovviamente postulando che la produzione energetica mondiale continui a basarsi prevalentemente sull'utilizzo del petrolio e di fonti fossili. Molti economisti sono critici nei confronti delle teorie collegate al picco del petrolio poiché considerano il bene energia come lo è il petrolio come bene sostituibile da un bene non energetico ma che la tecnologia eleva alla classe di bene energetico in caso di crisi mondiale dell'energia. In pratica si immagina che in caso di crisi e di prezzi elevati del greggio possano arrivare "naturalmente" una o più scoperte o un generale affinamento della tecnologia che riesca ad utilizzare meglio o sostituire il bene petrolio e ne faccia calare il prezzo. Per questo motivo economisti come Michael Lynch del MIT e molti altri avversano le teorie probabilistiche del peak oil poiché non si contemplano nuovi metodi per produrre energia. Si fa notare inoltre come la domanda petrolifera sia sostanzialmente anelastica ai prezzi, ovvero che il petrolio sia un bene primario, del quale non si può fare a meno; se a un certo punto gli investimenti necessari all'estrazione divengono proibitivi, la produzione non cesserà perché incontrerà una domanda comunque disposta a remunerarli. La teoria di Hubbert poi considera solamente logiche di mercato, mentre la produzione può essere finanziata in parte dall'intervento statale o da forme differenti per le quali l'investimento del privato ritorna remunerativo, e solo una parte dei costi è caricata sul consumatore.

Pila a combustibile

Una pila a combustibile (detta anche cella a combustibile dal nome inglese fuel cell) è un dispositivo elettrochimico che permette di ottenere elettricità direttamente da certe sostanze, tipicamente da idrogeno ed ossigeno, senza che avvenga alcun processo di combustione termica. L'efficienza delle pile a combustibile può essere molto alta; alcuni fenomeni però, come la catalisi e la resistenza interna, pongono limiti pratici alla loro efficienza. Il principio alla base delle pile a combustibile è quello della generazione diretta, a partire dalle sostanze reagenti (per esempio idrogeno e ossigeno) di una forza elettromotrice per mezzo di una reazione elettrochimica, in modo analogo alle pile elettriche, anziché attraverso processi di conversione di energia, come si fa invece nei generatori elettrici azionati da macchine a combustione termica. Infatti, il calore generato dalla combustione non può essere completamente convertito in elettricità a causa dei limiti imposti dal teorema di Carnot, che consegue dal secondo principio della termodinamica: in base a esso, la massima efficienza ηmax di una macchina termica che opera tra una temperatura Ta e una temperatura più bassa Tb (per esempio l'ambiente) è:

Anche nelle macchine termiche più efficienti, quali le turbine a gas combinate con turbine a vapore, a causa dei limiti dei materiali di costruzione, raramente l'efficienza può superare il 60%, e questo può avvenire solo su impianti a ciclo combinato di elevata potenza. Nei motori a combustione delle più moderne automobili, l'efficienza è spesso al di sotto del 30%. La reazione elettrochimica si basa sull'idea di spezzare le molecole del combustibile o del comburente (di solito ossigeno atmosferico) in ioni positivi ed elettroni; questi ultimi, passando da un circuito esterno, forniscono una corrente elettrica proporzionale alla velocità della reazione chimica, e utilizzabile per qualsiasi scopo. In pratica, la scelta dei combustibili è molto limitata, perché ionizzare molte molecole è difficile, e la reazione risulta avere una grande energia di attivazione, che a sua volta rallenta la reazione e rende l'uso pratico impossibile. L'idrogeno è un gas in grado di essere ionizzato facilmente, perché la sua molecola è costituita da due atomi legati da un legame relativamente debole (H-H); molto più debole, per esempio, di quello tra atomi di idrogeno e carbonio nella molecola del metano (CH4). Il comburente piu tipicamente usato è l'ossigeno dell'aria: non solo reagisce con l'idrogeno dando un prodotto innocuo come l'acqua, ma è anche disponibile in abbondanza e gratuitamente dall'atmosfera. Tuttavia, il doppio legame (O=O) tra gli atomi nella molecola dell'ossigeno è più forte che nel caso della molecola di idrogeno, e l'ossigeno rappresenta spesso un ostacolo maggiore nella catalisi delle reazioni elettrochimiche; si parla in gergo tecnico di sovratensione catodica, visto che l'ossigeno viene consumato al catodo della cella, e che una parte della tensione generata dalla cella viene assorbita per promuovere la reazione dell'ossigeno. In figura è mostrato lo schema di funzionamento di una pila a combustibile.

Pila chimica

La pila, in chimica, è un dispositivo che converte energia chimica in energia elettrica. All'interno di una pila avviene una reazione di ossido-riduzione in cui una sostanza subisce ossidazione, perdendo elettroni, ed un'altra subisce riduzione, acquistandoli. Data la sua configurazione, la pila consente di intercettare e sfruttare il flusso di elettroni tra le due sostanze. Tale flusso genera una corrente elettrica continua, il cui potenziale elettrico è funzione delle reazioni di ossidazione e riduzione che vi avvengono. Una pila si scarica quando queste reazioni chimiche raggiungono lo stato di equilibrio. Nel 1799 Alessandro Volta riprese gli studi di Luigi Galvani sulla corrente elettrica, riuscendo a realizzare la prima pila (oggi detta voltaica), con i seguenti costituenti:

- Un supporto di legno posto verticalmente su una base circolare

- Dischetti di rame e zinco

- Panno imbevuto di una soluzione acida formata da acqua e acido solforico

- Due fili di rame

La pila consiste in dischetti di rame e zinco alternati, seguendo la logica rame, zinco, umido, rame, zinco, e così via il tutto tenuto a posto dalla struttura di legno esterna. Una volta disposti i dischetti e il panno sul supporto, collegando il primo e l'ultimo dischetto della colonna con due fili di rame, si viene a creare tra essi una differenza di potenziale in grado di produrre il passaggio di corrente. In realtà Volta credeva che il passaggio di corrente fosse dovuto alla differenza di potenziale originatasi in seguito al semplice contatto dei due metalli, mentre ora si sa che il passaggio di corrente è dovuto alla differenza di potenziale creata dai due metalli, ma il passaggio di corrente è provocato dalle reazioni chimiche al quale concorre anche il mezzo umido. Infatti si può notare che nella pila così formata lo zinco si consuma mentre il rame rimane intatto (può eventualmente ossidarsi). Questo perché lo zinco cede due elettroni e passa da Zn metallico a Zn2+, questi elettroni contrariamente a quanto si possa pensare non passano al rame, che serve solo per creare la differenza di potenziale, ma passano allo ione ossonio H3O+ formatosi dalla dissociazione ionica dell'acido solforico in acqua, che si trasforma in idrogeno molecolare gassoso H2. Infatti la differenza di potenziale che si può misurare con un potenziometro è di ca. 0,7 V (solo di uno strato rame, umido, zinco) che equivale alla semicoppia Zn/Zn2+ utilizzando come altra semicoppia quella dell'idrogeno H2/H3O+. Il dispositivo così costituito permise a Volta di produrre una corrente elettrica, di cui osservò il flusso riuscendo a indurre la contrazione dei muscoli di una rana morta. Successivamente, nel 1836, John Frederic Daniell elaborò una pila, chiamata pila Daniell, sfruttando il prototipo inventato da Volta e apportando miglioramenti in termini di voltaggio e sicurezza d'uso. La cella è costituita da un compartimento anodico formato da una barretta di zinco immersa in una soluzione di solfato di zinco, ZnSO4 e un compartimento catodico formato da una barretta di rame immersa in una soluzione di solfato di rame(2+), CuSO4. Le due semicelle sono separate da un setto poroso. In entrambi i comparti deve essere presente un elettrolita di supporto quale ad esempio il solfato di potassio K2SO4. Alla chiusura del circuito esterno con un conduttore, al catodo avviene la semireazione di riduzione

Cu2+(aq) + 2 e → Cu(s) E°+ = 0,34 V

per cui del catione rame scompare dalla soluzione e si deposita come metallo sulla bacchetta; all'anodo avviene la semireazione di ossidazione

Zn(s) → Zn2+(aq) + 2 e E°- = - 0,76 V

per cui dello zinco si stacca come catione dalla barretta e va in soluzione. Si ha la reazione somma:

Zn(s) + Cu2+(aq) → Zn2+(aq) + Cu(s)

Per effetto di questa reazione nel comparto catodico mancherebbero cariche positive, mentre nel comparto anodico si avrebbe un eccesso di cariche positive dello zinco catione. Il tutto però viene compensato perché del catione potassio si sposta attraverso il setto poroso dal comparto anodico a quello catodico, ristabilendo l'elettroneutralità della soluzione. Gli elettroni nel circuito esterno girano dallo zinco al rame e quindi la corrente convenzionale positiva I, va dal rame allo zinco. Il potenziale teorico della pila Daniell è E° = E°+ - E°- = 1,10 V (ottenibile in condizioni quasistatiche reversibili), differenza tra il potenziale catodico (polo positivo) e quello anodico (polo negativo).

Le pile primarie, chiamate comunemente batterie, sono quelle pile le cui reazioni chimiche interne sono irreversibili. In altre parole, non è possibile invertire la reazione completa semplicemente fornendo energia alla pila; quindi, in sostanza, quando tutti i reagenti della pila si trasformano completamente nei prodotti finali, essa si scarica definitivamente divenendo inutilizzabile.

La prima pila a secco, cioè priva di elementi liquidi, prodotta industrialmente e commercializzata su ampia scala è la pila Leclanché, dal nome di Georges Leclanché. La paternità della prima pila a secco è, però, contesa tra Leclanché e Giuseppe Zamboni. La pila Leclanché è costituita da un anodo di zinco metallico, che funge anche da contenitore, e da un catodo costituito da una barretta di grafite, sulla cui superficie avviene la riduzione del biossido di manganese, miscelato a del cloruro d'ammonio a formare una pasta gelatinosa. La stechiometria della reazione di riduzione non è esattamente nota, tuttavia si può dire che le reazioni in una pila Leclanché sono le seguenti:

| ossidazione |

Zn → Zn2+ + 2 e- |

Eo = - 0,76 V |

| riduzione |

2 MnO2 + 2 NH4+ + 2 e- → 2 MnO(OH) + 2 NH3 |

Eo = 0,75 V |

| reazione complessiva |

Zn + 2 MnO2 + 2 NH4+ → Zn2+ + 2 MnO(OH) + 2 NH3 |

Eo = 1,51 V |

Rappresentazione schematica di una pila Leclanché; il catodo (+) è una barretta di grafite, il contenitore esterno di zinco funge da anodo (-)

Il cloruro d'ammonio, oltre a fornire gli ioni H+ per la reazione di riduzione, ha anche il compito di complessare gli ioni zinco prodotti dalla reazione di ossidazione

- Zn2+ + 2 NH4+ + 2 OH- → [Zn(NH3)2]2+ + 2 H2O

mantenendo quindi bassa la concentrazione degli ioni Zn2+ liberi, e quindi mantenendo elevato il potenziale della reazione di ossidazione, legato alle concentrazioni delle specie ossidata e ridotta secondo l'equazione di Nernst. L'ammoniaca che si libera al catodo tende a formare un velo gassoso sulla sua superficie, che impedisce il flusso degli elettroni. Quando questo avviene, la pila smette di erogare corrente e diviene scarica.

La pila Weston, che deve il suo nome al chimico inglese Edward Weston che la creò nel 1893, è una nota pila a umido di riferimento utilizzata in laboratorio per la calibrazioni di strumenti di misura quali i voltmetri e i potenziometri. L'anodo è costituito da un amalgama Cd/Hg al 12,5% in Cd, mentre il catodo è formato da una pasta di solfato di mercurio(1+) (Hg2SO4) depositata su mercurio metallico. L'elettrolita è comune alle due celle ed è rappresentato, nella versione originaria ideata da Weston, da una soluzione satura di solfato di cadmio CdSO4; nelle moderne versioni si utilizza invece una soluzione insatura, onde avere una minore variabilità del potenziale erogato in funzione della temperatura. La forza elettromotrice della pila originaria vale 1,0183 V a 20°C.

- Reazione chimica all'anodo (ossidazione)

- Cdamalg. -> Cd2+ + 2 e-

- Reazione chimica al catodo (riduzione)

- Hg2SO4 + 2 e- → 2 Hg + SO42-

- Usi: calibrazione di strumenti di misura quali voltmetri e potenziometri

- Vantaggi: forza elettromotrice costante nel tempo e che presenta piccolissima variazione in funzione della temperatura (elevata riproducibilità)

- Svantaggi: utilizzo di mercurio tossico, necessaria calibrazione periodica della pila insatura con una cella che utilizza la versione satura

Le pile alcaline sono l'evoluzione delle pile a secco. Sostanzialmente la loro struttura è identica. Tuttavia le batterie alcaline utilizzano una pasta, alcalina appunto, di idrossido di potassio (KOH) come elettrolita. Questa innovazione è fondamentale e ha il vantaggio di non produrre gas durante il funzionamento e di non avere cadute di tensione. La differenza di potenziale ai poli è di 1,5 V.

Reazione chimica all'anodo (ossidazione)

Zn + 2 OH- ? ZnO + H2O + 2 e-

Reazione chimica al catodo (riduzione)

MnO2 + 2 H2O + 2 e- ? Mn(OH)2 + 2 OH-

Reazione completa

Zn + MnO2 + H2O ? ZnO + Mn(OH)2. Usi: torce elettriche, giocattoli, strumenti elettronici vari. Vantaggi: tempo di vita più lungo, nessuna caduta di tensione anche ad elevata intensità di corrente erogata. Svantaggi: costo, più elevato rispetto alle pile a secco.

Le pile a mercurio hanno tipicamente una forma “a bottone”. Utilizzano un anodo di zinco e un catodo di acciaio e l'elettrolita è sempre una pasta alcalina di idrossido di potassio (KOH). La differenza di potenziale ai poli è di 1,3 V. Reazione chimica all'anodo (ossidazione)

- Zn + 2OH- -> ZnO + H2O + 2e-

Reazione chimica al catodo (riduzione)

- HgO + H2O + 2e- -> Hg + 2OH-

Reazione completa

- Zn + HgO -> ZnO + Hg

- Usi: Orologi, calcolatrici

- Vantaggi: Dimensioni ridotte, voltaggio relativamente alto

- Svantaggi: Il mercurio è un metallo pesante molto tossico e pericoloso per l’ambiente

Le pile ad argento sono molto simili a quelle a mercurio. Utilizzano un anodo di zinco e un catodo di argento e l'elettrolita è sempre una pasta alcalina di idrossido di potassio (KOH). La differenza di potenziale ai poli è di 1,6 V.

Reazione chimica all'anodo (ossidazione)

- Zn + 2OH- -> ZnO + H2O + 2e-

Reazione chimica al catodo (riduzione)

- Ag2O + H2O + 2e- -> 2Ag + 2OH-

Reazione completa

- Zn + Ag2O -> ZnO + 2Ag

- Usi: Macchine fotografiche, pacemaker cardiaci, alcuni apparecchi elettronici di precisione

- Vantaggi: Dimensioni ridotte, voltaggio relativamente alto e molto stabile

- Svantaggi: Costo molto elevato

Le pile secondarie, o accumulatori, sono quelle pile le cui reazioni chimiche interne sono reversibili. A differenza delle pile primarie, somministrando energia elettrica a questi dispositivi, si inverte il senso della reazione completa ottenendo la riformazione dei reagenti iniziali a spese dei prodotti finali. Di fatto, quindi, la pila si ricarica.

Accumulatore al piombo. La cella piombo-acida è il costituente fondamentale dei comuni accumulatori per auto. Utilizzano un anodo fatto di polvere di piombo (Pb) spugnosa e un catodo di diossido di piombo (PbO2). L'elettrolita è una soluzione di acido solforico (H2SO4) 4,5 M. La differenza di potenziale ai poli è di 2,1 V infatti negli accumulatori per automobili troviamo sei celle piombo-acide in serie, che generano una differenza di potenziale complessiva di 12 V. Negli accumulatori moderni, infine, si utilizza una lega di piombo che inibisce l’elettrolisi dell’acqua, potenzialmente pericolosa in quanto producendo idrogeno e ossigeno gassosi è a rischio di esplosioni.

Reazione chimica all'anodo (ossidazione)

- Pb + HSO4- -> PbSO4 + H+ + 2e-

Reazione chimica al catodo (riduzione)

- PbO2 + 3H+ + HSO4- + 2e- -> PbSO4 + 2H2O

Reazione completa

- PbO2 + Pb + 2H2SO4 -> 2PbSO4 + 2H2O

- Usi: Alimentazione automobili e camion

- Vantaggi: Eroga correnti molto elevate, affidabile e di lunga vita, funziona bene a basse temperature

- Svantaggi: Il piombo è un metallo pesante ed è tossico. Perdita di capacità dovuta a stress meccanici

Le pile al nichel-metallo idruro (NiMH) stanno ormai sostituendo le vecchie batterie al nichel-cadmio (NiCd), più tossiche e meno efficienti. All’anodo abbiamo l’ossidazione dell’idrogeno assorbito su leghe metalliche di nichel, al catodo abbiamo la riduzione del nichel (III) e l'elettrolita è sempre una pasta basica di idrossido di potassio. La differenza di potenziale ai poli è di 1,2 V.

Reazione chimica all'anodo (ossidazione)

- MH + OH- -> M + H2O + e-

Reazione chimica al catodo (riduzione)

- NiO(OH) + H2O + e- -> Ni(OH) 2 + OH-

Reazione completa

- MH + NiO(OH) -> M + Ni(OH)2

- Usi: Apparecchiature elettroniche portatili varie, tra cui telefoni cordless, cellulari, videocamere. Lentamente sostituita da quella al litio.

- Vantaggi: Leggera e potente.

- Svantaggi: Si scarica anche se non utilizzata, “effetto memoria”.

I moderni accumulatori al litio sono potenti e leggeri, anche se ancora relativamente costosi. All’anodo abbiamo degli atomi di litio “immersi” in strati di grafite, il catodo è un suo sale (solitamente LiMn2O4) e l'elettrolita è una soluzione di perclorato di litio LiClO4 in etilencarbonato C2H4CO3, un solvente organico. La differenza di potenziale ai poli è di 3,7 V.

Reazione chimica all'anodo (ossidazione)

- Lix -> x Li+ + x e-

Reazione chimica al catodo (riduzione)

- Li1-xMn2O4 + x Li+ + x e- -> LiMn2O4

Reazione completa

- Lix + Li1-xMn2O4 -> LiMn2O4

- Usi: Apparecchiature elettroniche moderne, computer portatili, cellulari, videocamere.

- Vantaggi: Estremamente potente e leggera: solo 7 grammi di metallo producono fino ad una mole di elettroni. Nessun “effetto memoria”.

- Svantaggi: Piuttosto costosa, il solvente può essere infiammabile. Se non sono applicati alcuni accorgimenti possono letteralmente esplodere in modo spettacolare (e pericoloso)

Pila zinco-aria

Il tipo di batteria ricaricabile più propriamente definibile pila zinco-aria, ma più noto come accumulatore zinco-aria ha come caratteristica peculiare quella di impiegare l'ossigeno atmosferico come elettrodo che riceve elettroni (si riduce) e lo zinco come elettrodo che perde elettroni (si ossida), il movimento di elettroni genera una differenza di potenziale e quindi una tensione elettrica che può servire per alimentare vari tipi di circuito elettrico. Gli accumulatori zinco-aria appartengono alla categoria delle celle a combustione, dove lo zinco è il combustibile e l'ossigeno è il comburente. Quando le superfici degli elettrodi di zinco metallico si sono ossidate diventando ossido di zinco, la batteria può considerarsi scarica. La batteria non può essere ricaricata dall'utente, ma deve essere sostituita "al volo" da un altro pacchetto di queste batterie nuove. Il vecchio pacchetto viene "ricaricato" a parte (in realtà il diossido di zinco viene "rigenerato", con una procedura elettro-chimica viene deossidato a zinco metallico) nell'industria o nella stazione di servizio automatizzata che si occuperà di questo ciclo industriale. Un Kg di batteria zinco-aria fornisce circa 110-200 chilowatt/ora, questo è da circa 6,8 a 10,2 volte la densità energetica di un comune accumulatore piombo-acido (il più utilizzato nelle odierne automobili). In base a calcoli teorici e perfezionamenti tecnologici si potrebbe arrivare a densità energetiche fino a 1000 Wh/Kg. Il costo di produzione è inferiore a quello degli accumulatori piombo-acido.

Vantaggi.

- Rispetto all' accumulatore nichel-cadmio si hanno lievi vantaggi nel rapporto carica/peso, la non presenza di metalli pesanti tossici da smaltire in discarica, e la totale inesistenza dell' effetto memoria.

- Rispetto all' accumulatore litio-ione si hanno enormi vantaggi nella durata (soprattutto ad alte temperature) e soprattutto nella sicurezza (non hanno alcuna tendenza ad incendiarsi se danneggiate).

- Rispetto all' accumulatore piombo-acido il vantaggio principale è quello del molto maggiore rapporto carica/peso, del minor costo del metallo, e dell'assenza di metalli pesanti da smaltire in discarica.

Svantaggi.

- Le pile zinco-aria risentono molto della bassa temperatura e dell'umidità e inquinamento, che portano ad una riduzione della reattività dell'ossigeno atmosferico. In condizioni ideali, come luoghi caldi e desertici, si nota un aumento della potenza massima e dell'autonomia del veicolo (vedasi il test del 1997 in California). Esattamente il contrario avviene ad alta quota (dove cala la pressione parziale dell'ossigeno), ed in climi freddi ed umidi come in caso di pioggia, che vedono ridursi sia la potenza massima che l'autonomia del veicolo.

- Non è possibile ricaricare queste battterie in casa e tantomeno impiegarle nel recupero dell'energia di frenata, o collegarle ad un generatore alimentato da un motore a combustione interna oppure il ricaricarle con celle solari sulla carrozzeria, ecc. Associandole ad altri tipi di batteria, si potrebbe ricuperare una parte dell' energia frenante o quella solare incidente tramite celle foto-voltaiche.

Piovosità anni 2012-2013.

Vedi articolo.

Pirolisi

La pirolisi è un processo di decomposizione termochimica di materiali organici, ottenuto mediante l’applicazione di calore e in completa assenza di un agente ossidante (normalmente ossigeno). In pratica mentre riscaldando il materiale in presenza di ossigeno avviene una combustione che genera calore e produce composti gassosi ossidati, effettuando invece lo stesso riscaldamento in condizioni di assenza totale di ossigeno il materiale subisce la scissione dei legami chimici originari con formazione di molecole più semplici. Il calore fornito nel processo di pirolisi viene quindi utilizzato per scindere i legami chimici, attuando quella che viene definita omolisi termicamente indotta. Tra i principali processi pirolitici sfruttati su larga scala spiccano il cracking industriale e il trattamento termico dei rifiuti. Prima del 1925 la pirolisi del legno costituì la fonte principale di metanolo. La pirolisi dei rifiuti, utilizzando temperature comprese tra 400 e 800°C, converte il materiale dallo stato solido in prodotti liquidi (cosiddetto tar o olio di pirolisi) e/o gassosi (syngas), utilizzabili quali combustibili o quali materie prime destinate a successivi processi chimici. Il residuo carbonioso solido ottenuto può venire ulteriormente raffinato fornendo prodotti quali ad esempio il carbone attivo. I prodotti della pirolisi sono sia gassosi, sia liquidi, sia solidi, in proporzioni che dipendono dai metodi di pirolisi (pirolisi veloce, lenta, o convenzionale) e dai parametri di reazione. Un pirolizzatore si differenzia da un gassificatore in quanto lavorando in assenza di ossigeno (spesso si sfrutta un flusso caldo di un gas inerte quale l'azoto) attua la pirolisi propriamente detta, mentre un gassificatore in realtà lavorando in presenza di piccole quantità di ossigeno realizza anche una parziale ossidazione e come tecnologia rappresenta una via di mezzo tra l'inceneritore e il pirolizzatore. Uno dei maggiori problemi legati alla produzione di energia basata sui prodotti della pirolisi è la qualità di detti prodotti, che non ha ancora raggiunto un livello sufficientemente adeguato con riferimento alle applicazioni, sia con turbine a gas sia con motori diesel. In prospettiva, anche con riferimento alle taglie degli impianti, i cicli combinati ad olio pirolitico appaiono i più promettenti, soprattutto in impianti di grande taglia, mentre motori a ciclo diesel, utilizzanti prodotti di pirolisi, sembrano più adatti ad impianti di piccola potenzialità. La pirolisi diretta viene generalmente attuata in apparecchiature (caldaie) in cui avviene anche lo scambio di calore tra i gas di combustione ed i fluidi di processo (acqua, olio diatermico, ecc.). La combustione di prodotti e residui agricoli si attua con buoni rendimenti, se si utilizzano come combustibili sostanze ricche di glucidi strutturati (cellulosa e lignina) e con contenuti di acqua inferiori al 35%. I prodotti utilizzabili a tale scopo sono i seguenti:

- legname in tutte le sue forme;

- paglie di cereali;

- residui di raccolta di legumi secchi;

- residui di piante oleaginose (ricino, cartamo, ecc.);

- residui di piante da fibra tessile (cotone, canapa, ecc.);

- residui legnosi di potatura di piante da frutto e di piante forestali;

- residui dell’industria agro-alimentare.

Le caldaie a letto fluido rappresentano la tecnologia più sofisticata e dispendiosa che sta ricevendo, però, notevoli attenzioni; infatti essa permette il conseguimento di numerosi vantaggi quali la riduzione degli inquinanti e l’elevato rendimento di combustione. Esistono molte tecnologie particolari: il sistema Thermofuel®, ad esempio, permette di ottenere, a partire dalla plastica, diesel sintetico attraverso pirolisi condotta a temperature più basse (370-420 °C). La pirolisi può essere anche utilizzata come parte integrante di altri processi quali il trattamento meccanico-biologico e la digestione anaerobica.

Politica europea per l'energia

All'inizio del 2007 l'Unione europea (UE) ha presentato una nuova politica energetica, espressione del suo impegno a favore di un'economia a basso consumo di energia più sicura, più competitiva e più sostenibile. Una politica comune rappresenta la risposta più efficace alle sfide energetiche attuali, che sono comuni a tutti gli Stati membri. Essa pone nuovamente l'energia al centro dell'azione europea, di cui è stata all'origine con i trattati che hanno istituito la Comunità europea del carbone e dell'acciaio (trattato CECA) e la Comunità europea dell'energia atomica (trattato Euratom), rispettivamente nel 1951 e nel 1957. Gli strumenti di mercato (essenzialmente imposte, sovvenzioni e sistema di scambio di quote di emissione di CO2), lo sviluppo delle tecnologie energetiche (in particolare le tecnologie per l'efficienza energetica e le energie rinnovabili, o le tecnologie a basso contenuto di carbonio) e gli strumenti finanziari comunitari sostengono concretamente la realizzazione degli obiettivi della politica. Comunicazione della Commissione al Consiglio europeo e al Parlamento europeo, del 10 gennaio 2007, dal titolo "Una politica energetica per l'Europa" [COM(2007) 1].

Potenza elettrica

In elettrotecnica la potenza è definita come il lavoro svolto da una carica elettrica in un campo elettrico nell'unità di tempo. Si tratta semplicemente della definizione data in fisica nel caso particolare in cui le uniche forze presenti siano quelle dovute al campo elettrico. Esprimendola tramite le grandezze usate in elettrotecnica si ottiene:

dove p(t) è la potenza entrante (uscente) in una porta di un componente n-porta se la tensione v(t) e la corrente i(t) sono misurati con un verso che rispetti la convenzione degli utilizzatori (convenzione dei generatori). Generalmente la potenza espressa in funzione del tempo viene chiamata potenza istantanea per distinguerla dalle grandezze usate nei sistemi periodici (che sono invece delle medie sul periodo).

Potenza di picco (Wp)

È la potenza massima prodotta da un dispositivo fotovoltaico in condizioni standard di funzionamento (irraggiamento 1000 W/m2 e temperatura 25°C).

Potenza nominale

La potenza nominale (o massima, o di picco, o di targa) dell’impianto fotovoltaico è la potenza elettrica dell’impianto determinata dalla somma delle singole potenze nominali (o massime, o di picco, o di targa) di ciascun modulo fotovoltaico facente parte del medesimo impianto, misurate alle condizioni standard (temperatura pari a 25 °C e radiazione pari a 1.000 W/m2).

Potenziale elettrico

Data una regione di spazio in cui è presente un campo elettrico, si definisce potenziale elettrico in un punto il valore dell'energia potenziale rilevato da una carica elettrica positiva di prova posta in quel punto per unità di carica. L'energia potenziale della carica è il livello di energia che la carica possiede a causa della sua posizione all'interno del campo elettrico; pertanto il potenziale elettrico della carica di prova è il rapporto tra l'energia potenziale e il valore della carica stessa, cioè:

Il potenziale è dunque una quantità scalare e non dipende dal valore della carica di prova. L'unità di misura del potenziale elettrico è il "volt" (simbolo V). Si dice che tra due punti A e B di una regione di spazio sede di un campo elettrico c'è una differenza di potenziale di 1 V se la forza elettrica compie il lavoro di 1 J per portare una carica di 1 C da A a B. Il potenziale elettrico, noto anche con il nome di potenziale scalare, viene indicato dalla lettera V, o a volte anche dalla lettera greca φ. Esso si ricava a partire dal lavoro del campo elettrico su una carica q:

Se vogliamo calcolare il lavoro lungo una linea l da un punto A ad un punto B dobbiamo calcolare l'integrale:

Potenziamento dell’impianto fotovoltaico

Il potenziamento è l’intervento tecnologico eseguito su un impianto entrato in esercizio da almeno due anni, consistente in un incremento della potenza nominale dell’impianto, mediante aggiunta di moduli fotovoltaici la cui potenza nominale complessiva sia non inferiore a 1 kW.

Prefisssi del Sistema Internazionale (SI)

Vedi Zetta.

Processi energetici

Processi che comportano generazione o consumo di energia.

Produttore

Persona fisica o giuridica che produce energia elettrica, indipendentemente dalla proprietà dell’impianto di produzione.

Punto di connessione alla rete

Punto di confine tra la rete del distributore o del gestore e la rete o l’impianto del cliente.

Punto di consegna

Punto in cui l'energia elettrica viene immessa in rete (generalmente una centrale elettrica).

PWR

Vedi:: Reattore nucleare a fissione.

Punto di riconsegna

Punto in cui l'energia elettrica viene prelevata dalla rete (generalmente un'impresa).

Radiazione solare

Energia elettromagnetica che viene emessa dal sole in seguito ai processi di fusione nucleare che in esso avvengono. La radiazione solare (o energia) al suolo viene misurata in kWh/m2.

Rapporti Enea Energia - Ambiente.

2009-2010. 2007 - 2008. 2006.

Reattore nucleare a fissione

Un reattore nucleare a fissione è un sistema complesso in grado di gestire una reazione a catena in modo controllato e utilizzato come componente base nelle centrali nucleari che possono contenere più reattori nucleari nello stesso sito. Esistono reattori nucleari di ricerca, nei quali l'energia prodotta è trascurabile e reattori di potenza, utilizzati dalle centrali nucleari nei quali l'energia termica prodotta sotto forma di vapore acqueo viene convertita in energia elettrica attraverso turbine e alternatori. Allo stato attuale tutti i reattori nucleari si basano sul processo di fissione nucleare sebbene vi siano importanti studi su reattori a fusione nucleare che in futuro dovrebbero sostituire o affiancare gli attuali reattori a fissione.

Per una buona precisine scientifica occorre sapere che i primi 16 reattori a fissione nucleare naturale divennero critici circa 1,7 miliardi di anni fa. In Gabon, nelle 3 miniere di Oklo, sono stati trovati minerali di uranio con concentrazione anormalmente bassa di 235U; il fenomeno è stato spiegato, grazie anche al ritrovamento di altri prodotti di decadimento, con la formazione naturale di concentrazioni di 235U superiori (1,7 miliardi di anni fa) al 3 %, e disposte in modo da costituire massa critica. Oggi questo non è più possibile a causa del più veloce decadimento dell' 235U rispetto all' 238U, la cui concentrazione è ormai ovunque molto più bassa, attorno allo 0,7 %.

Il primo reattore nucleare di costruzione umana è quello realizzato dall'équipe di Enrico Fermi a Chicago, nel reattore CP-1 (Chicago Pile-1), in cui si ottenne la prima reazione a catena controllata ed autosostenuta il 2 dicembre 1942. Quasi contemporaneamente venivano allestiti ad Oak Ridge l'impianto pilota l'X-10 (critico nel 1943) nell'ambito del laboratorio MetLab e a Hanford il B-reactor (critico nel settembre 1944), ambedue finalizzati alla produzione di plutonio, il primo come unità pilota ed il secondo per la produzione in grande scala. Nel dicembre 1954 il reattore di Obninsk, URSS divenne critico, e fu il primo reattore nucleare per uso civile; esso produceva solo 5 MW elettrici, ma fu comunque un precursore. Come i successori della filiera sovietica, era un reattore del tipo acqua-grafite, in cui il raffreddamento del nocciolo veniva assicurato da acqua leggera e la moderazione dei neutroni da blocchi di grafite, ottimo conduttore del calore oltre che efficace moderatore del flusso neutronico. Nel 1954 il reattore BORAX (Borax-I) divenne critico, ma non avendo turbine, non produceva energia elettrica. Dopo l'aggiunta delle turbine (e il cambio di nome a Borax-II), nel 1955 questo iniziò a produrre commercialmente energia elettrica, fornendo la cittadina che lo ospitava (Arco, Idaho, USA), se pure in piccola quantità (6,4 MW). Borax, a differenza del predecessore Obninsk-1 e del successore Calder Hall, era di tipo BWR (Boiling Water Reactor, o reattore ad acqua bollente, in cui il fluido di raffreddamento è acqua leggera) in cambiamento di fase. Nel 1956, infine, parte il primo reattore commerciale di grande potenza, e quindi economicamente significativo, quello di Calder Hall, in Cumbria, Regno Unito (50 MW), del tipo gas-grafite. In Italia, la prima centrale (sempre del tipo gas-grafite GEC-Magnox, acquistata dall'Inghilterra) fu quella di Latina, critica (cioè "accesa") il 27 dicembre 1962 e che produceva 153 MWe (megawatt elettrici), seguita da quella del Garigliano (1963), del tipo BWR General Electric a ciclo duale, da 150 MWe e da quella di Trino Vercellese (1964), del tipo PWR Westinghouse, da 260 MWe. L'IAEA a giugno 2008 elencava 439 reattori nucleari a fissione in attività e 34 in costruzione destinati alla produzione di energia, soprattutto in oriente (Cina, India, Russia, Korea).

Qualunque sia la tipolgia di reattore, esso ha alcuni componenti fondamentali. La sorgente di energia è il combustibile presente nel nocciolo del reattore, composto da materiale fissile (tipicamente una miscela di 235U e 238U), arricchita fino al 5% in 235U, che, producendo neutroni e subendo la fissione ad opera degli stessi, emette energia sotto forma di calore. Questo calore è asportato da un fluido refrigerante (gassoso o liquido, o che subisce un cambio di fase nel processo) che lo trasporta ad un utilizzatore, quasi sempre un gruppo turbo-alternatore per la produzione di energia elettrica. Un moderatore, solitamente grafite o acqua leggera (Fermi negli esperimenti sui neutroni termici a Roma utilizzò la paraffina, comunque elementi contenenti molto idrogeno), rallenta la velocità dei neutroni in modo da aumentare l'importanza delle fissoni termiche dell'235U. Le barre di controllo sono barre metalliche (in genere leghe di argento, cadmio e indio o carburi di boro) atte ad assorbire neutroni, ovviamente senza emetterne a loro volta; possono essere inserite nel nocciolo e servono per tenere sotto controllo ed eventualmente arrestare la reazione a catena di fissione. Il combustibile quindi genera in continuazione una certa quantità (fissa) di neutroni, e quando i sistemi di controllo (le barre) sono non inserite (almeno parzialmente), la quantità statistica di neutroni che scompaiono nel nocciolo è pari alla quantità di neutroni prodotti dallo stesso: questo è il cosiddetto punto di criticità del reattore. Al di sopra di questo punto il reattore si dice sovra-critico.

I reattori cosiddetti "provati" sono quelli di cui è stata verificata la stabilità operativa per usi civili commerciali. Oggi sono conosciuti vari tipi di reattore nucleare, generalmente classificati in base al tipo di combustibile utilizzato, al sistema di raffreddamento/generazione vapore e al tipo di moderatore. I primi modelli, come si è visto, a partire dal CP-1, erano del tipo gas-grafite, poi commercialmente sviluppato in varie versioni tra cui le principali sono i reattori Magnox (Magnesium Uranium Oxide) (GEC) e RBMK. Ambedue usavano (in realtà vi sono parecchi reattori RBMK tuttora in uso, e qualche Magnox nella versione Advanced Gas Cooled Reactor) uranio arricchito come combustibile. Il grande vantaggio dei modelli a gas è nella possibilità di utilizzare fluidi inerti come fluido refrigerante, evitando così i problemi di corrosione propri dell'acqua ad alta temperatura (che inoltre, quando irradiata, si scinde parzialmente nei componenti, generando pericoloso idrogeno nonché ossigeno libero che aggrava ulteriormente i problemi di corrosione) e nella bassa densità del refrigerante che non assorbe quindi neutroni in maniera significativa. Il problema maggiore, viceversa, sta nel relativamente basso coefficiente di scambio termico del gas, e nell'impossibilità di ottenere la moderazione dei neutroni attraverso il fluido stesso, obbligando quindi all'utilizzazione di costose (e instabili, a temperature elevate) strutture in grafite o all'utilizzo dell'acqua. Si sono quindi affermati i modelli raffreddati (e moderati) ad acqua, che sostanzialmente sono delle caldaie in cui il focolare è sostituito dall'insieme degli elementi di combustibile. Di questi esistono due modelli, o filiere: quelli in cui la vaporizzazione dell'acqua avviene a contatto degli elementi di combustibile, o comunque nello stesso recipiente che le contiene, detti di tipo BWR (Boiling Water Reactor - si vedano anche sopra i dati del Borax), che quindi inviano in turbina un vapore più o meno debolmente radioattivo, e quelli che utilizzano un circuito intermedio, per cui un fluido refrigerante (di solito ancora acqua) entra a contatto del combustibile, si scalda e, senza cambiare di fase, circola in un generatore di vapore esterno in cui cede calore ad altra acqua, che stavolta vaporizza e genera energia elettrica nel gruppo turbina-alternatore. Sono detti PWR (Pressurized Water Reactor). Il vapore che arriva in turbina in condizioni di normale funzionamento non è più radioattivo. Vi sono stati tentativi di utilizzare combustibili meno costosi (ossia uranio non arricchito, normalmente presente in natura), e sono stati proposti due modelli di reattore simili, e studiati in parte in collaborazione: il CiReNe (CISE Reattore a Nebbia), sviluppato originariamente dal Centro Italiano Studi Esperienze dell'ENEL, ed il CANDU (Canada Deuterium Uranium) sviluppato dall'Atomic Energy Commission Canadese. Questi reattori, per ovviare alla relativamente debole economia neutronica dovuta ad un tenore ridotto di 235U, utilizzano come fluido refrigerante e moderatore acqua pesante, che ha una bassissima sezione d'urto (ossia probabilità) di cattura dei neutroni. La differenza tra le due filiere sta nel circuito di raffreddamento, ad acqua bollente per il CiReNe (da cui il nome di reattore a nebbia), che lo qualifica come BHWR (Boiling Heavy Water Reactor), e ad acqua pressurizzata per il CANDU, che lo qualifica come PHWR (Pressurized Heavy Water Reactor). La filiera CANDU ha avuto una sua affermazione commerciale soprattutto in Canada ed in nazioni potenzialmente interessata alle sua capacità plutonigene (India, Argentina) mentre il progetto CIRENE è stato sospeso prima della sua conclusione, a causa della moratoria nucleare italiana, durante la realizzazione dell'impianto prototipo a Latina. Vanno citati, tra i reattori di potenza, quelli utilizzati per la trazione. Le necessità, in questo caso, sono quelle di leggerezza e ottimo contenimento delle radiazioni: a tale scopo, la filiera PWR è generalmente usata, in quanto permette di tenere turbine e generatori in zona sicura, essendo il fluido esente da radiazioni. In realtà il circuito primario è stato realizzato anche con fluidi diversi, come nel reattore italiano R.O.S.P.O. (Reattore Organico Sperimentale Potenza Zero), realizzato come prototipo per la futura (e mai realizzata) nave Enrico Fermi a propulsione nucleare, in cui venivano utilizzati prodotti organici cerosi, simili ai comuni oli diatermici - sempre allo scopo di ridurre le dimensioni. Malgrado i molti progetti (la nave tedesca Otto Hahn, quella americana Savannah, e altre sono state effettivamente realizzate, ma senza grande successo), la propulsione nucleare è oggi usata solo nei sottomarini militari (e alcuni di ricerca), nelle grandi portaerei e nei rompighiaccio russi della classe Lenin.

Reattore nucleare a fusione.

Un reattore nucleare a fusione è un ipotetico sistema in grado di gestire una reazione di fusione nucleare in modo controllato. Allo stato attuale non esistono reattori nucleari a fusione operativi per produrre energia elettrica, ma gli unici impianti operativi sono piccoli impianti di ricerca in grado di sostenere la reazione di fusione nucleare per un tempo molto ridotto. Essendo la fusione nucleare una forma di energia molto interessante che potrebbe in teoria fornire energia all'umanità per un tempo illimitato si stanno effettuando ingenti investimenti in questo tipo di reattori anche se si ritiene che i primi impianti potrebbero essere operativi non prima del 2050. Tra i vari progetti di ricerca il più ambizioso attualmente è il progetto internazionale ITER. Il progetto ITER punta a sviluppare un reattore sperimentale in grado di sostenere una reazione di fusione nucleare per diversi minuti. Il progetto ITER ha un budget di 10 miliardi di Euro e va sottolineato che non mira a produrre direttamente energia elettrica ma punta a dimostrare la capacità dell'impianto di sostenere una reazione nucleare controllata basata sulla fusione nucleare che produca più energia di quanta ne consumi. Oggi è in corso la costruzione in scala 1:1 del primo reattore per la fusione del progetto ITER. Nel sito scelto di Cadarache in Francia è prevista la produzione del primo plasma [ primo feedback di processo ] entro il 2019. La produzione di energia elettrica verrà demandata al progetto successivo chiamato DEMO. DEMO si avvantaggerà dell'esperienza derivata dal progetto ITER e integrerà il reattore con tutte le infrastrutture necessarie alla produzione di energia elettrica in modo efficiente. Per ottenere una buona resa energetica il reattore del progetto DEMO dovrà essere necessariamente più grande del reattore ITER anche se le dimensioni definitive sono ancora oggetto di studio. Dopo lo sviluppo del progetto DEMO si potrà progettare una centrale nucleare a fusione per uso industriale che quindi tenga in debita considerazione anche gli aspetti economici. La denominazione provvisoria in ambito europeo del progetto successivo a DEMO è PROTO. I materiali che entrano nella reazione sono il deuterio, facilmente reperibile in natura, ed il trizio, che invece, a causa del suo breve periodo di decadimento, non è presente in natura. La reazione è: deuterio (2) + trizio (3) —> elio(4) + neutrone. Questo comporta che sia la centrale a dover generare la quantità di trizio richiesta per le reazioni nucleari che dovranno produrre energia (per ITER è prevista una richiesta di trizio di circa 250 g/d, mentre per DEMO, che dovrà funzionare in continuo, la richiesta sarà sensibilmente più elevata). Pertanto uno dei componenti chiave della futura centrale energetica a fusione sarà il blanket, che è la parte di centrale in cui i neutroni di reazione reagiscono con il litio 6 per produrre trizio La reazione è: litio(6) + neutrone —> elio (4) + trizio (3) .

Reattore nucleare AP1000 (Reattore a sicurezza passiva). Il reattore di tipologia AP1000 è una tipologia di reattore di III generazione prodotta dalla Toshiba-Westinghouse Electric Company, sarà la prima tipologia di reattore di III Generazione a ricevere l'approvazione dall'ente di regolamentazione per il nucleare americano (NRC). Questa tipologia di reattori è essenzialmente la versione potenziata del modello AP600 (il suo predecessiore), che riesce a generare, però, fino a 1154 MW. Gli AP1000 sono fra gli ipotetici reattori che l'Italia è intenzionata a costruire per il suo nuovo piano nucleare, essendo la Ansaldo Nucleare licenziataria della Westinghouse per l'Europa, ed uno dei maggiori fornitori per i reattori AP1000 cinesi, ed avendo firmato l'Italia un piano d'intesa con gli USA per scambio di conoscenze nell'ambito nucleare. In Cina la filiera AP1000 è molto quotata, infatti nei propositi della Westinghouse e della Cina c'è l'intento di avere 100 o più reattori AP1000 in funzione o in costruzione per il 2020. Gli Scopi principali del progetto sono quelli di fornire un reattore con sicurezze maggiori, maggiore economicità della centrale e quindi competitività economica e semplificazione costruttiva, tramite una collaudata filiera di reattori PWR Westinghouse. L'AP1000 è un reattore ad acqua pressurizzata PWR a due loop, con potenza elettrica in uscita di circa 1154 MW. I sistemi di sicurezza sono incentrati sulla sicurezza passiva del reattore e sulla semplificazione in fatto di sicurezza e costruzione, questi permettono di avere alti coefficienti di sicurezza senza l'utilizzo di gruppi elettrogeni i caso di mancanza di corrente dall'esterno (come invece è necessario oggi per avere la certezza di alimentare i sistemi interni). In caso di incidente, il reattore non richiede l'intervento di un operatore per un lungo periodo, questo fa si che la possibilità di errore umano nell'emergenza sia molto ridotto, e si da anche tempo per la mobilitazione di assistenza che pervenga da fuori la centrale. La probabilità di inconvenienti è ulteriormente diminuita tramite l'utilizzo di moderni dispositivi, che sono anche ridondanti per permettere che nel caso uno fallisca, un altro entri subito in funzione senza compromettere la sicurezza, in questo modo gli effetti di potenziali conseguenze per malfunzionamenti della macchina sono molto ridotti. Ulteriori sistemi di sicurezza sono poi passivi, quindi non richiedono l'intervento umano per l'attivazione, questi sono la gravità e la convezione naturale dell'aria, che permettono (tramite le taniche di acqua sistemate sulla sommità del reattore) di raffreddare il reattore naturalmente per molte ore dopo un inconveniente grave, questo sistema è chiamato PCCS, acronimo di Passive Core Cooling System ed entra in funzione automaticamente. Le valvole in questo sistema sono infatti alimentate dalla corrente nella posizione di chiusura, venendo a mancare l'alimentazione queste si aprono e liberano il liquido refrigerante. La sicurezza di un impianto è calcolata essere, per danneggiamento grave del nocciolo, 2.41 × 10-7, molto al di sotto delle richieste dell'ente regolatore (10-4).

Reattore nucleare di IV generazione

I reattori nucleari di IV generazione (Gen IV) sono un gruppo di 6 famiglie di progetti per nuove tipologie di reattore nucleare a fissione che, pur essendo da decenni allo studio, non si sono ancora concretizzati in impianti utilizzabili diffusamente in sicurezza. Si ritiene saranno disponibili commercialmente fra alcune decine di anni (2030-2040). Non si tratta delle uniche possibilità di sviluppo dopo la 3° generazione: la ricerca sulla "4° gen." è stata promossa dal Forum Internazionale GIF (Generation IV International Forum) fondato nel 2000 dal Department of Energy degli Stati Uniti d'America (DOE) ed a cui hanno aderito alcuni paesi. Rappresenta una proposta di evoluzione del settore, non l'unica. Inoltre, non tutti i paesi che hanno firmato il documento d'intenti del GIF hanno poi firmato effettivi protocolli di collaborazione tecnologica. Molti tipi di reattore sono stati considerati all'inizio del programma GIF; comunque, la lista è stata ridotta per focalizzarsi sulle tecnologie più promettenti e soprattutto su quelle che potevano più probabilmente soddisfare gli obiettivi dell'iniziativa "Gen IV". Tre sistemi sono nominalmente reattori termici ed altri tre sono reattori autofertilizzanti a neutroni veloci. Alcuni possono essere teoricamente implementati come termici o come veloci. Il sistema VHTR é inoltre studiato per la capacità teorica di generare calore di alta qualità (cioè ad altissima temperatura) per la produzione d'idrogeno impiegabile forse in un futuro nelle celle a combustibile o per altre applicazioni industriali. Tuttavia non ha un ciclo del combustibile chiuso. I reattori a neutroni "veloci" offrono la possibilità di "bruciare" molti tipi di elementi della serie degli attinidi e di produrre più combustibile nucleare di quello che consumano (in gran parte plutonio, con i rischi connessi). Il reattore MSR si caratterizza anche per la possibilità di usare torio e di essere autofertilizzante anche usando neutroni "lenti" (termici).

Reattore nucleare europeo ad acqua pressurizzata

Il reattore nucleare europeo ad acqua pressurizzata, meglio noto con la sigla EPR (European Pressurized Reactor) è un reattore nucleare di III generazione, a fissione, nel quale la refrigerazione del nocciolo e la moderazione dei neutroni vengono ottenuti grazie alla presenza nel nocciolo di acqua naturale (detta anche leggera per distinguerla dall'acqua pesante) in condizioni sottoraffreddate. Il reattore è quindi della tipologia PWR. È stato progettato e sviluppato principalmente dalla società francese Framatome (Areva NP) per il mercato Europeo, in particolare quello francese dominato dal gruppo EdF ma è prevista la sua esportazione sia sul mercato cinese, dove sono in costruzione 2 reattori per il sito Taischan 1 nella provincia del Guangdong, che sul mercato USA nella versione US-EPR, sottoposta alla certificazione del progetto da parte dell'ente di controllo NRC alla fine del 2007. I principali scopi del progetto dell'EPR sono un'aumentata sicurezza e, allo stesso tempo, una migliore competitività economica, tramite miglioramenti graduali e collaudati. Il reattore EPR può utilizzare come combustibili ossido di uranio arricchito al 5% oppure MOX (miscela di ossidi di uranio e plutonio) fino al 100% del nocciolo.

Il progetto del reattore nucleare EPR prevede molteplici sistemi di protezione sia attivi che passivi contro vari tipi di incidente:

- quattro sistemi indipendenti di refrigerazione d'emergenza, ognuno capace da solo di refrigerare il nocciolo del reattore dopo il suo spegnimento;

- un contenimento metallico attorno al reattore, a tenuta per le eventuali fuoriuscite di materiale radioattivo in caso di incidente con rottura del circuito primario;

- un contenitore (core catcher) ed un'area di raffreddamento passivo del materiale fuso, nell'improbabile evento che il nocciolo di combustibile nucleare radioattivo fuso possa fuoriuscire dal recipiente in pressione;

- doppia parete esterna in calcestruzzo armato, con uno spessore totale di 2,6 metri, progettata per resistere all'impatto diretto di un grosso aereo di linea.

Reattore Superphénix

Superphénix o SPX era una centrale elettrica nucleare francese sul fiume Rodano presso Creys-Malville, a circa 60km dal confine Svizzero e 100km dal confine italiano. Alimentata da un reattore nucleare veloce autofertilizzante sperimentale, ha terminato la produzione commerciale di energia elettrica nel 1996 e l'impianto è stato chiuso nel 1997. Il progetto della centrale iniziò nel 1968, dopo l'abbandono dei reattori gas-grafite. Si scelse un reattore autofertilizzante veloce per il timore di quegli anni di venire tagliati fuori dalle forniture energetiche (petrolio e uranio): la cosiddetta "economia del plutonio" sembrava, date le condizioni di quegli anni, una alternativa plausibile. La costruzione venne approvata nel 1972 e durò dal 1974 al 1981, ma la produzione di energia non iniziò fino al 1985. I costi salirono rapidamente durante la produzione. L'impianto fu condotto dal consorzio NERSA di cui la EDF deteneva il 51% ed ENEL il 33%. Ci furono molte proteste popolari durante la costruzione e l'operatività: una marcia di 60.000 persone nel luglio 1977 fu dispersa dalle forze dell'ordine francesi con un morto e oltre un centinaio di feriti.